L’AI sta prendendo il sopravvento

Secondo una recente ricerca condotta da NewsGuard, sarebbero oltre 700 i siti di notizie creati e popolati dall’intelligenza artificiale che operano con poca o con nessuna supervisione umana. Si tratta dei cosiddetti UAIN, dall’inglese “unreliable AI-generated news”, ovvero notizie inaffidabili generate dall’AI.

Ma come sono fatti questi siti artificiali?

Questi siti di notizie prodotti dall’intelligenza artificiale – rivela la società autrice dell’analisi – sono presenti in 15 lingue diverse, tra cui anche l’italiano, hanno nomi generici “come iBusiness Day, Ireland Top News e Daily Time Update” e il più delle volte non rivelano la propria origine artificiale.

La creazione di false informazioni

Si tratta di piattaforme in grado di pubblicare decine di articoli ogni giorno su una vasta gamma di argomenti, tra cui tecnologia, politica, cronaca, sport e spettacolo. In alcuni casi (non raramente), questi articoli contengono imprecisioni o addirittura false informazioni, ma la loro individuazione non è agevole.

Molti di questi siti hanno un aspetto professionale e ben curato, il che li rende difficili da distinguere da testate giornalistiche reali. Tuttavia, spesso presentano articoli copiati o parafrasati da altre fonti oppure testi generati dall’intelligenza artificiale privi di approfondimento e/o fondamento.

Massimo business, minimo sforzo

Secondo NewsGuard, “in molti casi, il modello di guadagno per questi siti è la pubblicità programmatica, in base alla quale l’industria della tecnologia pubblicitaria fornisce annunci pubblicitari senza tenere conto della natura o della qualità del sito. Di conseguenza, marchi rinomati stanno involontariamente sostenendo questi siti“.

Il modello di business si ispira dunque al motto “massima resa con il minimo sforzo”. Gli sviluppatori di queste piattaforme predispongono siti web esteticamente validi con l’obiettivo di alimentarli attraverso l’intelligenza artificiale. Lo scopo non è quindi informare il pubblico, ma guadagnare dalla quantità di notizie pubblicate e contenenti annunci pubblicitari. Il focus è la quantità, non la qualità, e la conseguenza è la presenza in rete di un numero elevato di fake news.

La notizia rischia grosso

La diffusione di simili pratiche solleva preoccupazioni sulla disinformazione e sull’impatto che questi contenuti possono avere sull’opinione pubblica e, talvolta, sulle visioni politiche dei cittadini.

“Oltre ai siti inclusi nel Centro di monitoraggio – si legge nel report citato – gli analisti di NewsGuard hanno anche identificato un sito gestito dal governo cinese che cita informazioni generate dall’AI come fonte affidabile per sostenere la falsa teoria secondo cui gli Stati Uniti gestiscono un laboratorio di armi biologiche in Kazakistan. Secondo tale teoria, nel laboratorio verrebbero infettati dei cammelli per danneggiare la popolazione cinese”.

Come riconoscere le notizie generate dall’AI?

Individuare con certezza i contenuti testuali prodotti dall’intelligenza artificiale non è possibile. Ci sono però delle caratteristiche sintattiche e lessicali che possono fungere da indizio dell’origine artificiale del testo. Tra queste, la scelta di parole e strutture che risultano essere traduzioni letterali di termini inglesi e la presenza di ripetizioni e strutture meccaniche e poco fluide. Queste sono però considerazioni soggettive, che dipendono dalla sensibilità individuale.

Una soluzione più oggettiva potrebbe risiedere nell’apposizione di un watermark testuale, che consisterebbe nell’obbligare i modelli a utilizzare con una maggiore frequenza determinate parole. La presenza di questi termini in percentuali più elevate di quelle riscontrate nel linguaggio umano può indicare la natura artificiale del testo analizzato. Ma la realizzazione di una simile soluzione – funzionale per i modelli text-to-image – non è immediata per i modelli che producono contenuti testuali.

Gli esperti sottolineano dunque, in parallelo a questi accorgimenti, la necessità di una maggiore supervisione e trasparenza da parte di chi pubblica contenuti generati dall’intelligenza artificiale per contrastare la disinformazione e mantenere standard giornalistici elevati e il rispetto dei principi etici.

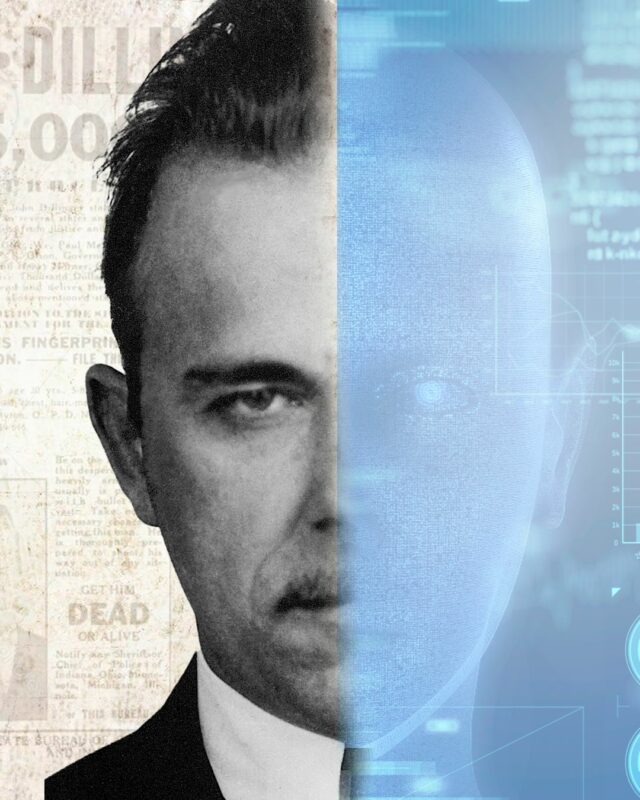

Voi comunque potete dormire tranquilli, perché Dillinger non pubblicherà mai articoli creati con l’AI.